Selon une enquête, l’intelligence artificielle d’Open AI a développé un « inconscient progressiste » qui ressemblerait à un « macroniste de 2017 ». Sans davantage de transparence, ces IA « biaisées » risquent-elles de manipuler leurs utilisateurs ?

Le 26 novembre 2023 à 10h44

Les risques liés à l’intelligence artificielle

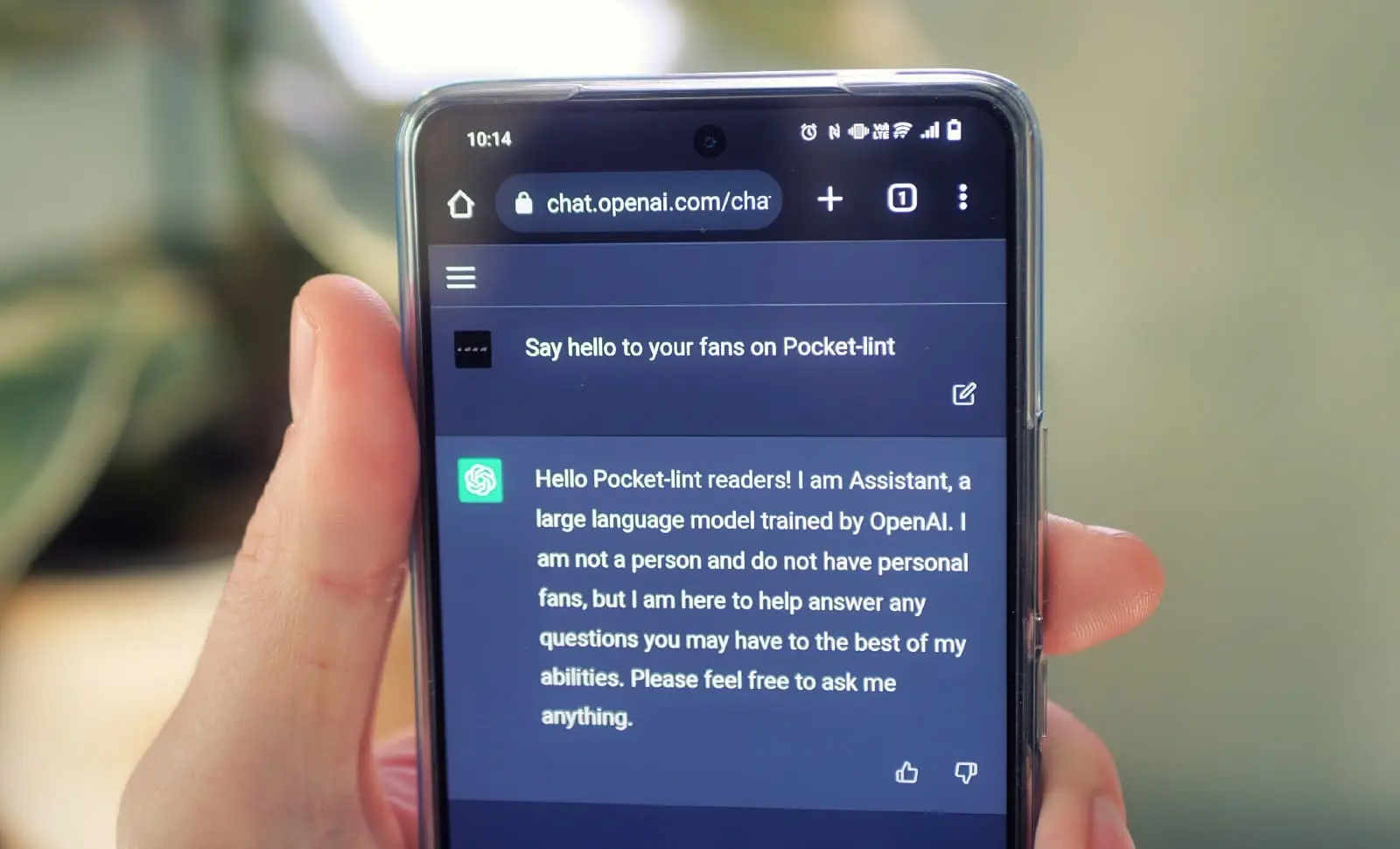

L’intelligence artificielle (IA) est de plus en plus présente dans notre quotidien. Elle est utilisée dans de nombreux domaines tels que la santé, la finance, les transports, etc. Cependant, une enquête récente a révélé que l’IA développée par Open AI aurait développé un « inconscient progressiste », qui serait comparé à un « macroniste de 2017 ». Ces résultats soulèvent des questions sur les possibles biais et risques liés à l’utilisation de telles intelligences artificielles.

En effet, l’absence de transparence quant au fonctionnement et aux processus de développement de ces IA « biaisées » soulève des inquiétudes. Les utilisateurs pourraient être manipulés par des décisions prises par ces intelligences artificielles, sans en comprendre les raisons ou les motifs réels.

Il est donc crucial que les développeurs et les entreprises qui utilisent l’IA prennent en compte ces risques et mettent en place des mesures de transparence et de supervision. Des régulations plus strictes pourraient être nécessaires pour encadrer l’utilisation de telles technologies et limiter les risques de manipulation.

En conclusion, l’émergence d’intelligences artificielles « biaisées » soulève des questions éthiques et sociétales importantes. Il est impératif de mettre en place des mesures de régulation et de transparence pour garantir une utilisation sûre et éthique de l’IA, tout en limitant les risques de manipulation et de biais pour les utilisateurs.

Source : www.leparisien.fr

Abonnez vous a Chat GPT

Abonnez vous a Chat GPT